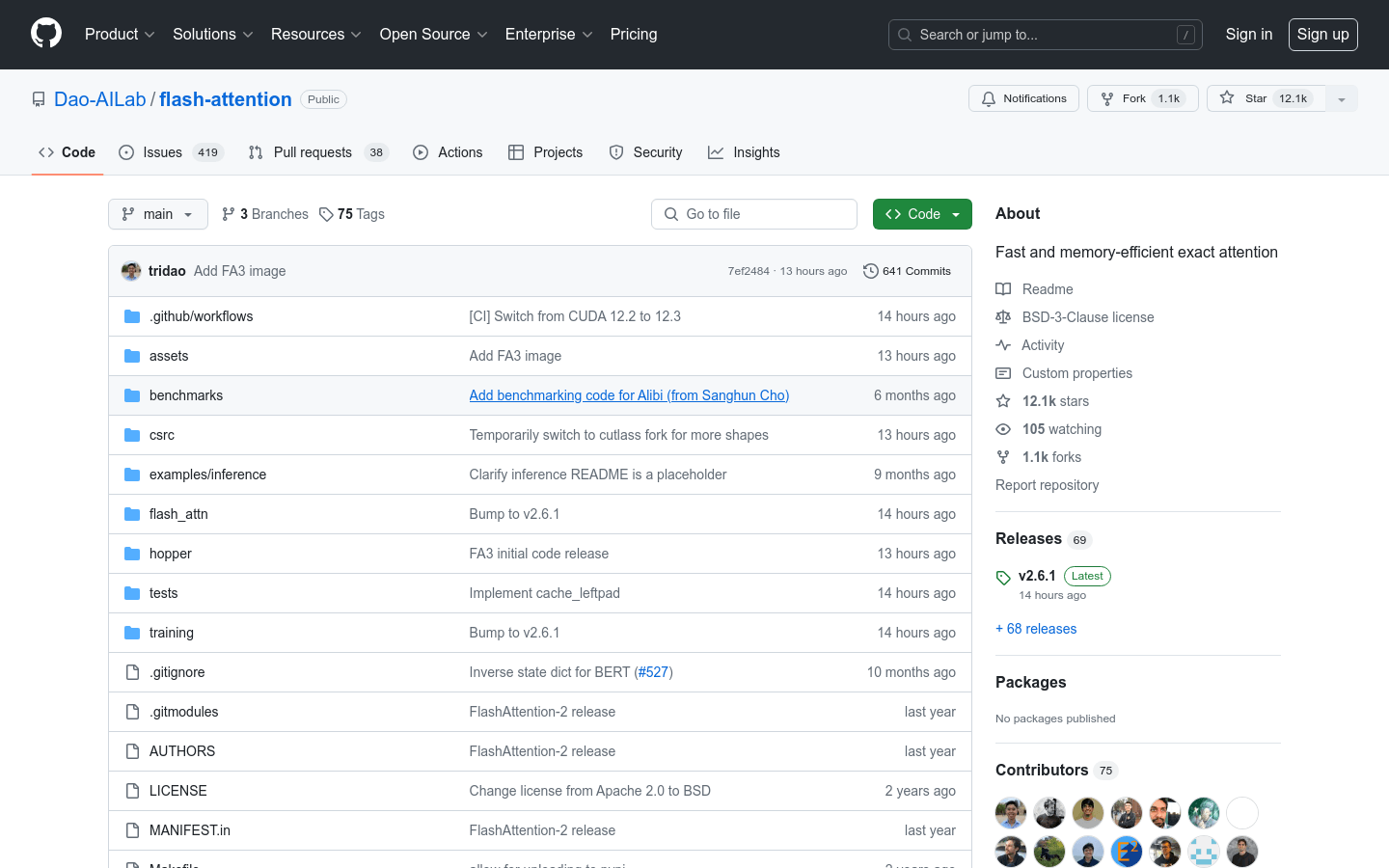

FlashAttention

快速且内存高效的精确注意力机制

- 支持多种GPU架构,包括Ampere、Ada和Hopper。

- 提供数据类型fp16和bf16的支持,针对特定GPU架构优化。

- 实现了可扩展的头维度,最高支持256。

- 支持因果注意力和非因果注意力,适应不同的模型需求。

- 提供了简化的API接口,便于集成和使用。

- 支持滑动窗口局部注意力机制,适用于需要局部上下文信息的场景。

产品详情

FlashAttention是一个开源的注意力机制库,专为深度学习中的Transformer模型设计,以提高计算效率和内存使用效率。它通过IO感知的方法优化了注意力计算,减少了内存占用,同时保持了精确的计算结果。FlashAttention-2进一步改进了并行性和工作分配,而FlashAttention-3针对Hopper GPU进行了优化,支持FP16和BF16数据类型。