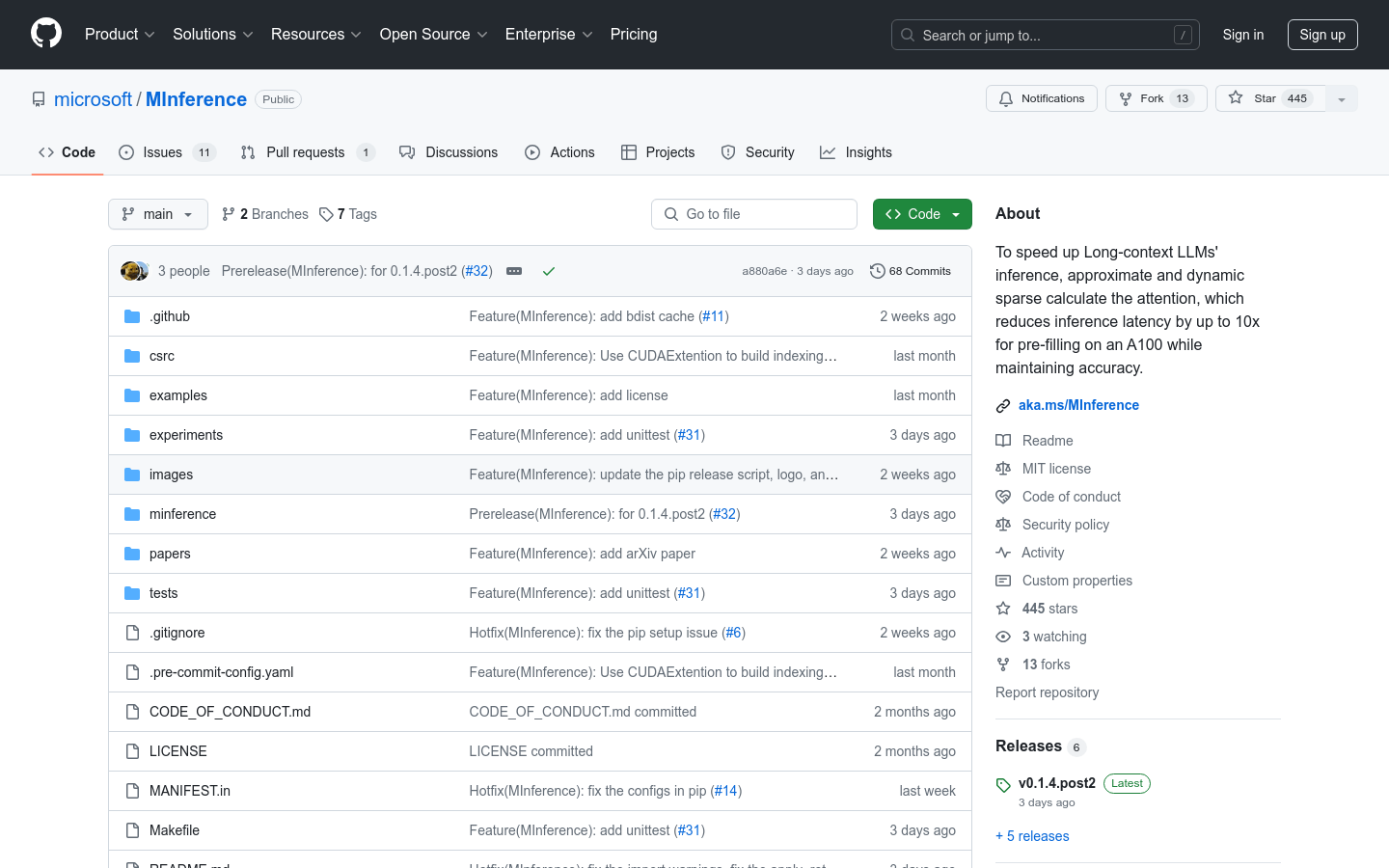

MInference

加速长上下文大型语言模型的推理过程

- 动态稀疏注意力模式识别:通过分析确定每个注意力头属于的稀疏模式。

- 在线稀疏索引近似:动态计算注意力,使用最优的自定义内核。

- 支持多种解码型大型语言模型:包括LLaMA风格模型和Phi模型。

- 简化安装过程:通过pip命令快速安装MInference。

- 提供丰富的文档和示例:帮助用户快速上手和应用MInference。

- 持续更新和社区支持:适应更多模型,不断优化性能。

产品详情

MInference是一个针对长上下文大型语言模型(LLMs)的推理加速框架。它利用了LLMs注意力机制中的动态稀疏特性,通过静态模式识别和在线稀疏索引近似计算,显著提升了预填充(pre-filling)的速度,实现了在单个A100 GPU上处理1M上下文的10倍加速,同时保持了推理的准确性。