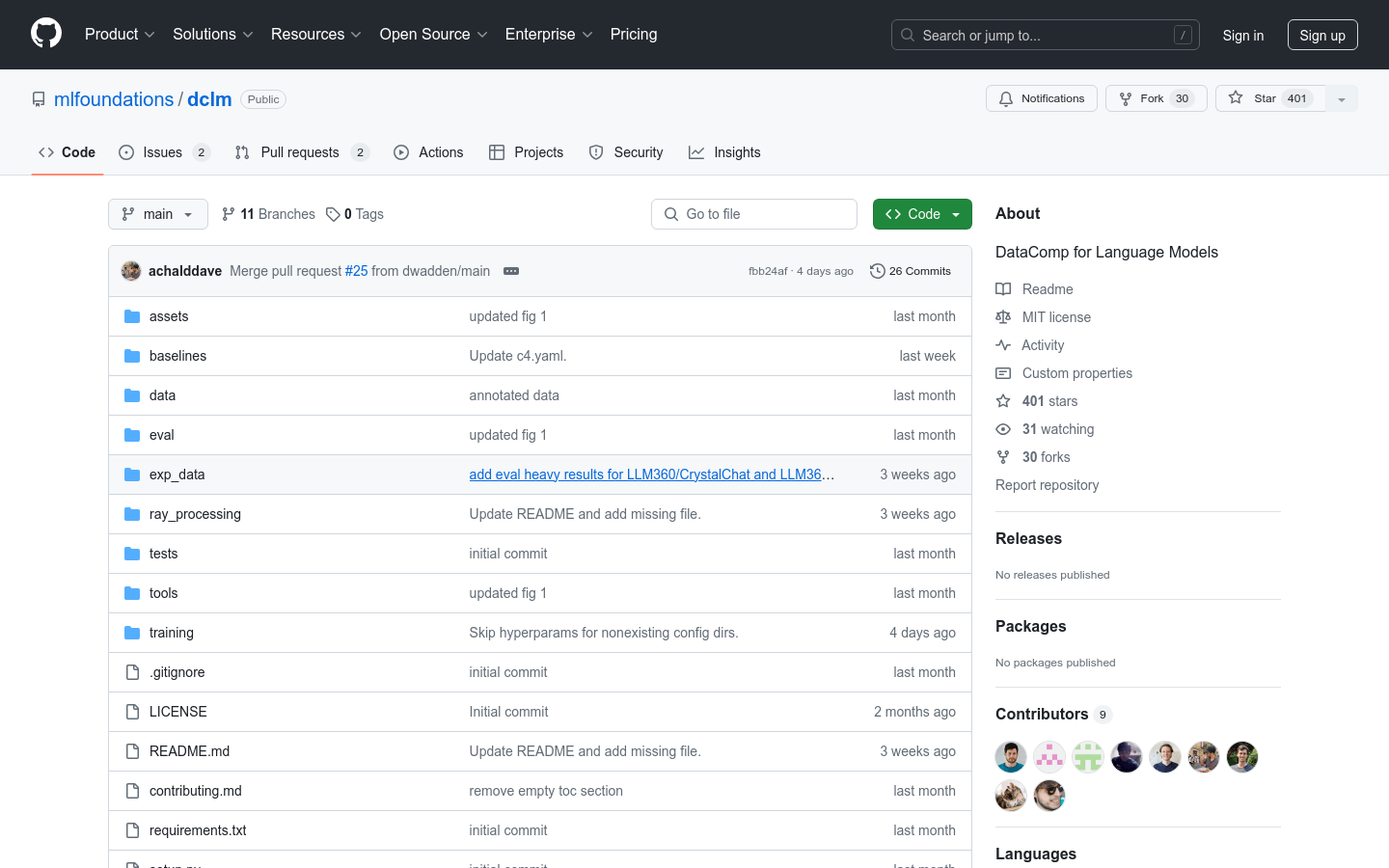

DCLM

构建和训练大型语言模型的综合框架

- 提供超过300T未过滤的CommonCrawl语料库

- 基于open_lm框架提供有效的预训练配方

- 提供超过50种评估方法来评估模型性能

- 支持从411M到7B参数模型的不同计算规模

- 允许研究人员实验不同的数据集构建策略

- 通过优化数据集设计提高模型性能

产品详情

DataComp-LM (DCLM) 是一个为构建和训练大型语言模型(LLMs)而设计的综合性框架,提供了标准化的语料库、基于open_lm框架的高效预训练配方,以及超过50种评估方法。DCLM 支持研究人员在不同的计算规模上实验不同的数据集构建策略,从411M到7B参数模型。DCLM 通过优化的数据集设计显著提高了模型性能,并且已经促成了多个高质量数据集的创建,这些数据集在不同规模上表现优异,超越了所有开放数据集。